Este artigo foi escrito por Mandeep Singh, analista sênior de setor da Bloomberg Intelligence, e Robert Biggar, analista associado. Publicado anteriormente no Terminal Bloomberg.

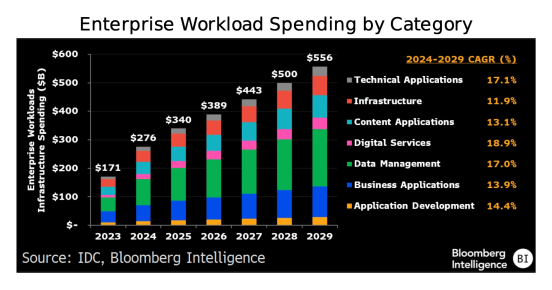

A migração do foco da inteligência artificial (IA), da construção de modelos para a inferência em grande escala, está direcionando a demanda dos data centers de IA para os bancos de dados, especialmente aqueles utilizados por chatbots, agentes de codificação e outros. Com isso, a carga de trabalho voltada ao desenvolvimento de aplicações, como os sistemas de gestão de relacionamento com o cliente, vem diminuindo, o que beneficia provedores de software como Oracle e MongoDB. Nos data centers de IA, os volumes de trabalho relacionados à entrega de conteúdo e à cibersegurança tendem a crescer rapidamente, em razão de seu papel fundamental na implementação dos agentes.

Agentes de IA direcionam a demanda dos data centers para a camada de dados

A tokenização de dados corporativos para alimentar chatbots, agentes de codificação e outros agentes de IA deverá impulsionar um crescimento acima da tendência na demanda por bancos de dados vetoriais, que funcionam como repositórios de dados empresariais não estruturados. À medida que as funções de negócios integrem modelos de IA a dados corporativos proprietários, provedores de software como Oracle e MongoDB tenderão a observar uma aceleração na demanda. Além do aumento no volume de dados voltados ao treinamento, espera-se uma inflexão na criação de bancos de dados e no consumo desses dados, à medida que os agentes se disseminem por diversos casos de uso.

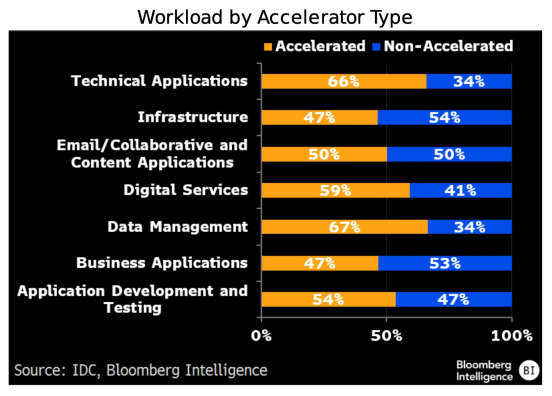

Diante da iteração intensiva que sustenta as capacidades avançadas, as empresas dependerão de data centers equipados com aceleradores para garantir o alto desempenho das cargas de trabalho na camada de banco de dados. Com a multiplicação de matrizes no núcleo de inferência dos grandes modelos de linguagem (LLMs), os bancos de dados vetoriais tendem a se tornar uma das principais categorias em termos de volume de trabalho, viabilizando maior escalabilidade e respostas mais rápidas.

Desaceleração à vista: cai o volume de trabalho em aplicações

À medida que os agentes de IA automatizam um número cada vez maior de etapas nos fluxos de trabalho diários, uma parcela menor dessas tarefas precisa ser executada por grandes pacotes de aplicativos. Isso indica um crescimento mais lento na demanda dos data centers por softwares de planejamento de recursos empresariais, gestão de relacionamento com o cliente, gestão de capital humano e gestão da cadeia de fornecimento.

Atualmente, agentes baseados em modelos de raciocínio e ferramentas de pesquisa profunda já conseguem navegar pela Web de forma autônoma, coletar fontes e realizar análises por conta própria – tarefas que antes eram executadas nas interfaces de usuário dos aplicativos. Os softwares de engenharia, como as ferramentas de projeto assistido por computador (CAD) e de manufatura assistida por computador (CAM), devem resistir melhor a esses desafios, já que a simulação e a geração de dados sintéticos mantêm as cargas de trabalho ancoradas em ferramentas especializadas.

Agentes de codificação impulsionam os volumes de trabalho de testes

Os agentes de codificação baseados em IA, assistentes integrados a ferramentas de desenvolvimento que sugerem, escrevem e corrigem códigos, devem dar um grande impulso às cargas de trabalho de desenvolvimento e teste de aplicativos. Agentes como Cursor, Claude Code, da Anthropic, Copilot, do GitHub, Codex, da OpenAI, e Code Assist, do Gemini, executam tarefas como depurar e anexar códigos existentes. As empresas vêm relatando ganhos de produtividade de 30% a 40% na escrita de novas linhas de código com esses agentes, o que deve direcionar ainda mais atividades de desenvolvimento e teste aos data centers de IA. A geração de código baseada em prompts está rapidamente se tornando um dos recursos de IA generativa mais utilizados nas aplicações atuais de negócios.

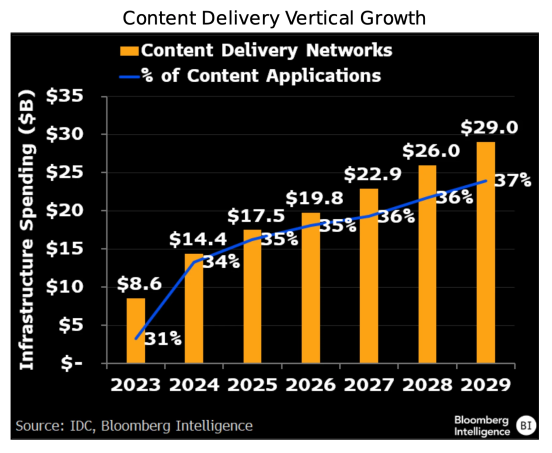

Benefícios para as áreas de conteúdo e cibersegurança

À medida que os agentes autônomos de IA se conectam aos workflows de negócios, tarefas mais críticas passarão a ser executadas nos data centers de IA. A ascensão de modelos de raciocínio, como o modelo o3 da OpenAI, desloca o foco para garantir que a infraestrutura seja rápida, eficiente e confiável, em vez de apenas dispor de um modelo. Esse movimento favorece as redes de entrega de conteúdo (CDNs) de empresas, como a Cloudflare, e de provedores de cibersegurança, como a Zscaler. A maioria das organizações busca integrar bases de conhecimento internas e documentação com modelos de linguagem de grande porte (LLMs), enquanto conta com fornecedores de CDN e de cibersegurança para gerenciar o consumo de tokens no ajuste fino e na inferência dos LLMs.