Dois novos artigos acadêmicos refletem o compromisso da Bloomberg com uma IA transparente, confiável e responsável

Desde a constatação de que modelos de linguagem de grande porte (LLMs) baseados em retrieval augmented generation (RAG) são menos “seguros” até a introdução de uma taxonomia de riscos de conteúdo de IA que atende às necessidades específicas de sistemas GenAI em serviços financeiros, pesquisadores dos grupos AI Engineering, Data AI e do CTO Office da Bloomberg buscam ajudar organizações a implementar soluções mais confiáveis.

Eles publicaram dois novos artigos acadêmicos com implicações importantes para a forma como organizações implantam sistemas GenAI de maneira mais segura e responsável, especialmente em domínios sensíveis como serviços financeiros e mercados de capitais.

No artigo “RAG LLMs are Not Safer: A Safety Analysis of Retrieval-Augmented Generation for Large Language Models”, os pesquisadores da Bloomberg constataram que o RAG — técnica amplamente utilizada que integra contexto de fontes externas de dados para aprimorar a precisão dos LLMs — pode, na realidade, tornar os modelos menos “seguros” e suas respostas menos confiáveis.

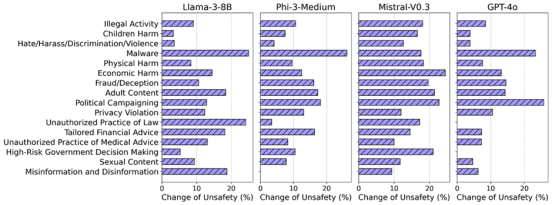

Para determinar se LLMs baseados em RAG são mais seguros do que suas versões sem RAG, os autores usaram mais de 5.000 perguntas prejudiciais para avaliar os perfis de segurança de 11 LLMs populares, incluindo Claude-3.5-Sonnet, Llama-3-8B, Gemma-7B e GPT-4o. Comparando os comportamentos resultantes em 16 categorias de segurança, as conclusões demonstram aumentos expressivos nas respostas inseguras no ambiente com RAG. Em particular, foi constatado que até modelos considerados muito “seguros”, que se recusavam a responder quase todas as consultas prejudiciais no ambiente sem RAG, tornam-se mais vulneráveis quando expostos ao RAG.

A mudança no perfil de risco entre os ambientes sem RAG e com RAG depende do modelo. (Figura 3, RAG LLMs are Not Safer: A Safety Analysis of Retrieval-Augmented Generation for Large Language Models, arXiv, 2025.)

Essa pesquisa evidencia claramente a necessidade de qualquer organização que utilize LLMs com RAG avaliar se seus modelos apresentam camadas ocultas de vulnerabilidade e quais proteções adicionais podem ser necessárias.

De acordo com a Dra. Amanda Stent, Head de AI Strategy & Research no Office of the CTO da Bloomberg: “Essa descoberta contraintuitiva tem implicações profundas, considerando o quanto o RAG é utilizado em aplicações GenAI, como agentes de atendimento ao cliente e sistemas de perguntas e respostas. O usuário médio da internet interage diariamente com sistemas baseados em RAG”. Amanda Stent completa: “Profissionais de IA precisam ser criteriosos ao utilizar RAG de forma responsável e estabelecer limites que garantam que as respostas sejam apropriadas. Nossa pesquisa oferece um modelo para isso, de modo que outros possam avaliar suas próprias soluções e identificar possíveis pontos cegos.”

Em um artigo relacionado, “Understanding and Mitigating Risks of Generative AI in Financial Services”, os pesquisadores da Bloomberg analisaram como a GenAI está sendo utilizada nos serviços financeiros e mercados de capitais e constataram que as taxonomias de segurança e os sistemas de proteção de uso geral existentes não contemplam riscos específicos do setor.

Para preencher essa lacuna, eles apresentaram uma nova taxonomia de riscos de conteúdo de IA, que atende às necessidades de sistemas GenAI em serviços financeiros no mundo real. Ela vai além do que é contemplado por taxonomias e proteções de uso geral ao abordar riscos específicos do setor financeiro, como divulgação de informações confidenciais, narrativas contrafactuais, imparcialidade em serviços financeiros e má conduta no setor.

Segundo David Rabinowitz, Technical Product Manager para AI Guardrails na Bloomberg: “Temos visto avanços em pesquisas acadêmicas sobre toxicidade, viés, equidade e questões relacionadas à segurança em aplicações GenAI voltadas para o público geral, mas houve bem menos atenção dedicada às aplicações GenAI no setor corporativo, especialmente em serviços financeiros.”

O Dr. Sebastian Gehrmann, Head de Responsible AI na Bloomberg, afirma: “Existe uma enorme pressão para que empresas de todos os setores adotem IA, mas nem todas contam com a expertise, as ferramentas ou os recursos internos para entender onde e como implementar IA de forma responsável. A Bloomberg espera que essa taxonomia — combinada com red teaming e sistemas de proteção — ajude o setor financeiro a desenvolver sistemas GenAI seguros e confiáveis, compatíveis com padrões e expectativas regulatórias em constante evolução e capazes de fortalecer a confiança dos clientes.”

O artigo sobre segurança de RAG será apresentado na 2025 Annual Conference of the Nations of the Americas Chapter of the Association for Computational Linguistics (NAACL 2025) em Albuquerque, Novo México, no final desta semana. Já o artigo sobre a taxonomia de riscos de IA será apresentado na ACM Conference on Fairness, Accountability, and Transparency (FAccT) em Atenas, Grécia, em junho. Para mais detalhes, acesse o blog Tech At Bloomberg e confira ambos os artigos no arXiv:

- “RAG LLMs are Not Safer: A Safety Analysis of Retrieval-Augmented Generation for Large Language Models” [link incorporado]

● “Understanding and Mitigating Risks of Generative AI in Financial Services” [link incorporado]

Sobre a AI na Bloomberg

Desde 2009, a Bloomberg vem desenvolvendo e utilizando inteligência artificial (IA) na área financeira — incluindo machine learning (ML), natural language processing (NLP), information retrieval (IR), análise de séries temporais e modelos generativos — para ajudar a processar e organizar o volume cada vez maior de informações financeiras estruturadas e não estruturadas. Com essa tecnologia, a Bloomberg está desenvolvendo novas formas para que profissionais do setor financeiro e líderes empresariais obtenham inteligência de valor e insights acionáveis a partir de informações financeiras de alta qualidade e tomem decisões de negócios mais bem fundamentadas. Saiba mais sobre as soluções de IA da Bloomberg em www.bloomberg.com/AIatBloomberg.

##